英雄榜:果尔网稿件征集启示

SEO优化案例分析 : 2013-11-23 14:25:27 - SEO资讯

你认可果尔网上的文章观点吗?你想把你心中的想法告诉大家吗?你愿意和果尔一起打造真正的纯SEO交流平台吗?……欢迎发送您的建议或意见,以及您的原创文章(请. ...

SEO优化案例分析 : 2013-11-23 14:25:27 - SEO资讯

你认可果尔网上的文章观点吗?你想把你心中的想法告诉大家吗?你愿意和果尔一起打造真正的纯SEO交流平台吗?……欢迎发送您的建议或意见,以及您的原创文章(请. ...

Posted:2013-11-27 09:13:33 - comments | 作者: @果尔 @ SEO培训学院 修订1.4 ID:7024

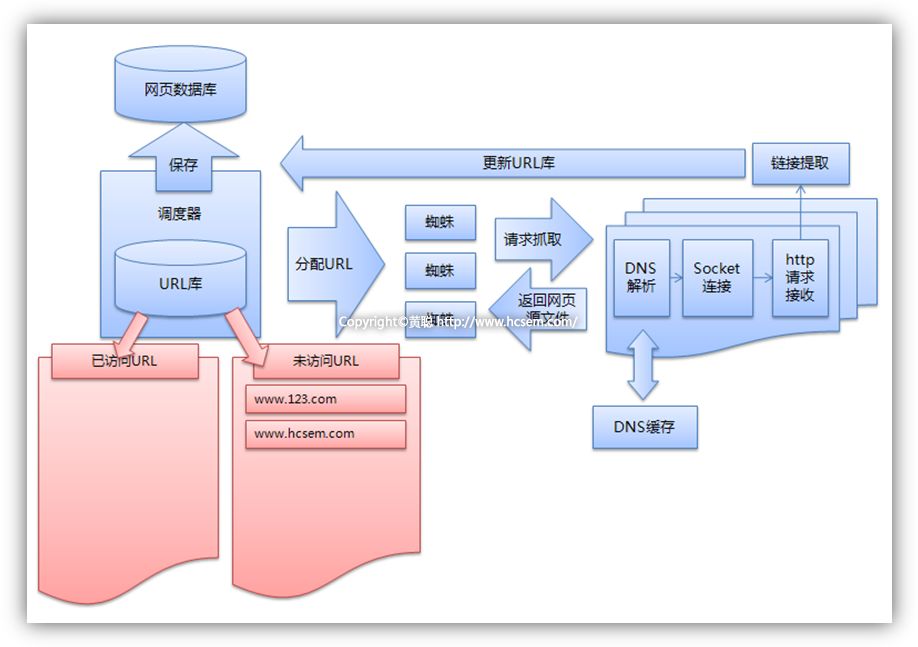

在《2.2、页面搜集原理、技术和系统–搜集过程》中我们知道调度器会派发URL给各个蜘蛛进行网页的抓取,但是怎样才能避免同一个URL会被重复的抓取呢?调度器是如何确保分配给每个蜘蛛都是最合理的呢?本文黄聪就和大家分析一下。

下面我们就看看调度器是怎么实现避免网页重复搜集的:

上图中,我们发现调度器中有一个重要的模块是URL库,URL库又由已访问URL库和未访问URL库来组成。调度器就和通过这个URL库来实现避免网页重复搜集的。

调度器的工作流程

小结

虽然调度器通过已访问URL表和未访问URL表理论上实现了避免网页重复搜集的问题,但是由于域名和IP存在一对一、一对多、多对一、多对多的情况,难免还是会存在个别网页重复搜集的问题,这些就不在本文展开来讲了。

果尔SEO,中国医疗美容机构SEO经验分享平台。本文头像LOGO署名文章版权所有,转载请注明出处。